Co to jest Crawling?

W SEO, 'crawling’ to proces, w którym robot wyszukiwarki przegląda strony internetowe, aby mogły być później zaindeksowane i ostatecznie sklasyfikowane. Te roboty są często nazywane 'robotami indeksującymi’ lub 'pająkami’. Dokładnie analizują wszystko, co mogą znaleźć na stronie.

Więcej O Robotach Indeksujących

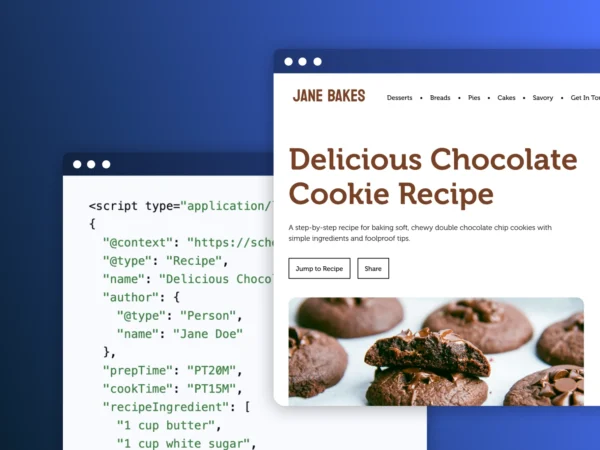

Gdy robot wyszukiwarki indeksuje stronę internetową, przegląda całą zawartość i kod, które może znaleźć. Obejmuje to zwykły tekst, obrazy i tekst alternatywny, linki itp.

Roboty indeksujące zauważają wszystkie linki znajdujące się na stronie i również je indeksują. W ten sposób właściciele stron mogą tworzyć ścieżki linków dla robotów. Aby pomóc botom szybciej i efektywniej przeszukiwać witrynę, warto rozważyć utworzenie mapy witryny XML.

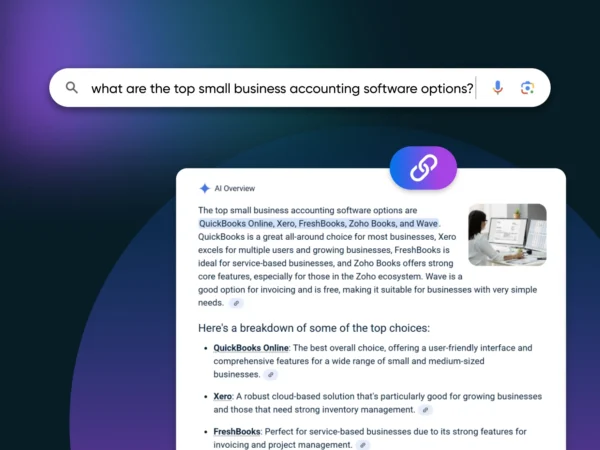

Gdy indeksowanie zostanie zakończone, roboty wyszukiwarek zapiszą i ’zaindeksują wszystkie znalezione dane. Następnie wykorzystają te informacje do ustalenia pozycji strony.